Appello a fermare la superintelligenza, mette a rischio l’umanità: migliaia di esperti lo firmano

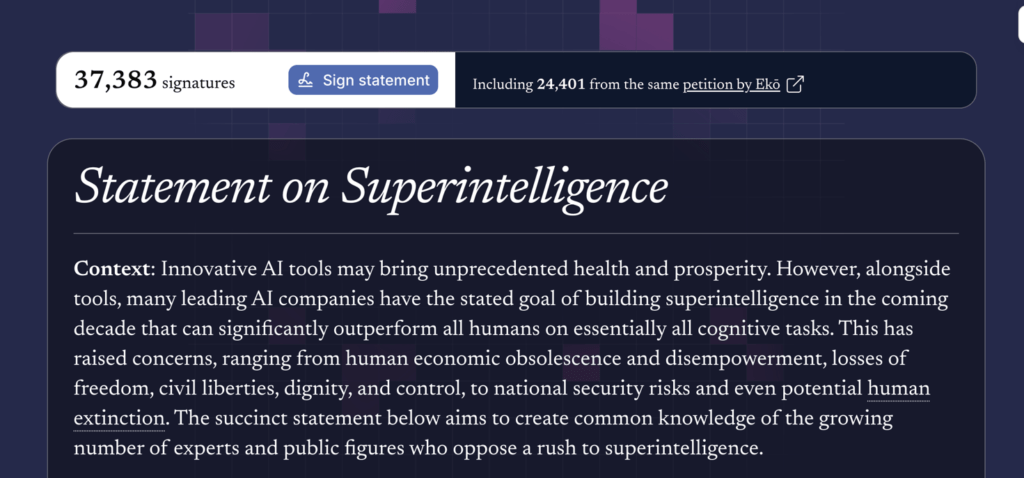

| Mentre scrivo le firme sono arrivate a 37.383. E sono firme pesanti. Di cosa si tratta? Di una brevissima dichiarazione sulla super intelligenza (artificiale) in cui i firmatari chiedono: il divieto dello sviluppo della superintelligenza, che non potrà essere revocato fino a quando non vi sarà: un ampio consenso scientifico sulla sua sicurezza e controllabilità e un forte sostegno da parte dell’opinione pubblica. La statement è preceduto da una altrettanto breve precisazione del contesto in cui nasce questo appello. Lo riporto integralmente: Contesto: gli strumenti innovativi di intelligenza artificiale possono portare benefici senza precedenti in termini di salute e prosperità. Tuttavia, oltre agli strumenti, molte aziende leader nel settore dell’intelligenza artificiale hanno dichiarato l’obiettivo di sviluppare nel prossimo decennio una superintelligenza in grado di superare significativamente le capacità di tutti gli esseri umani in quasi tutte le attività cognitive. Ciò ha sollevato preoccupazioni che vanno dall’obsolescenza economica e dalla perdita di potere degli esseri umani, alla perdita di libertà, diritti civili, dignità e controllo, fino ai rischi per la sicurezza nazionale e persino alla potenziale estinzione dell’umanità. La breve dichiarazione riportata di seguito mira a diffondere la consapevolezza del numero crescente di esperti e personaggi pubblici che si oppongono alla corsa alla superintelligenza. |

A dire il vero la super intelligenza artificiale (ASI) al momento non esiste (e secondo molti difficilmente esisterà in futuro). Se mai esisterà si tratterebbe comunque di una intelligenza (artificiale) in grado di superare tutti i livelli di conoscenza umana in tutte le attività cognitive e quindi di un sistema di IA che avrebbe in sé un potenziale distruttivo capace di portare all’estinzione dell’intera umanità, dei diritti e del potere degli esseri umani.

Si potrebbe qui discutere se davvero l’ASI è alla portata della attuale ricerca scientifica e anche se davvero questa intelligenza è comparabile (e per cosa) con l’intelligenza umana non artificiale. Al riguardo consiglio la lettura del volume Sovraumano. Oltre i limiti della nostra intelligenza di Nello Cristianini (che il direttore di Tecnica della Scuola ha qui intervistato).

I firmatari

Tra i firmatari troviamo al momento alcuni tra i massimi studiosi di intelligenza artificiale oltre a politici, uomini di cultura, scienziati (il sito https://superintelligence-statement.org/ permette di verificare tutte le diverse firme suddivise per categorie).

Ad esempio Geoffrey Hinton, premio Nobel e professore emerito di Scienze informatiche all’università di Toronto, il suo collega a Montreal, il canadese Yoshua Bengio, padre dell’intelligenza artificiale moderna e studioso più citato al mondo per questo settore di studi.

E ancora l’informatico Stuart Russel ma anche l’ex consigliere di Donald Trump Steve Bannon, i duchi del Sussex, Harry e Meghan Markle, Steve Wozniak, cofondatore di Apple, Richard Branson, fondatore del Virgin Group, Susan Rice, ex consigliera per la Sicurezza nazionale degli Stati Uniti, Mike Mullen, ex capo dello Stato maggiore congiunto statunitense, Glenn Beck fondatore di media.

L’appello si rivolge sia ai governi che alle grandi aziende tecnologiche e si deve al Future of Life Institute.

Così commenta Yoshua Bengio:

“I sistemi di intelligenza artificiale all’avanguardia potrebbero superare la maggior parte delle persone nella maggior parte delle attività cognitive nel giro di pochi anni. Questi progressi potrebbero sbloccare soluzioni alle principali sfide globali, ma comportano anche rischi significativi. Per avanzare in modo sicuro verso la superintelligenza, dobbiamo determinare scientificamente come progettare sistemi di intelligenza artificiale che siano fondamentalmente incapaci di danneggiare le persone, sia attraverso un disallineamento che un uso malevolo. Dobbiamo anche assicurarci che il pubblico abbia voce in capitolo nelle decisioni che plasmeranno il nostro futuro collettivo”.

Come si vede si tratta da un lato di capire come bloccare gli effetti malvagi dell’IA e di come progettare sistemi incapaci di danneggiare le persone, e dall’altro di restituire “potere” alle persone, ai cittadini.

Così, mentre in realtà l’intelligenza artificiale (e non la super intelligenza!!) sta già operando con sistemi d‘arma autonomi letali (LAWS: lethal autonomous weapon sistems), le società mondiali sono alle prese da un lato con la necessità di regolamentare l’IA (come fa l’Europa con l’AI Act) e dall’altro con la corsa a chi arriva prima. Corsa che vede ogni regolamentazione come un blocco che favorisce la concorrenza (i cinesi, nello specifico).

La scuola e le linee guida del MIM sull’IA

In mezzo i sistemi formativi, alle prese con la richiesta di un approccio etico basato sulla centralità dell’uomo (antropocentrico) e l’impegno a dotare i cittadini delle competenze necessarie per utilizzare in modo critico i sistemi di IA.

L’impressione è di essere dentro un frullatore in cui la forza dirompente degli interessi economici costringe un po’ tutti a entrare in un gioco di cui non si capisce bene l’esito.

E mentre scrivevo questo articolo le firme sono aumentate e ora (15,35) hanno raggiunto il numero di 37.575…

Il corso

Su questi argomenti il corso Le linee guida sull’Ia a scuola: cosa cambia?, a partire dal 29 ottobre.